Исследователи обнаружили, что алгоритм распознавания речи Whisper от OpenAI подвержен так называемым «галлюцинациям» — ошибкам, когда система выдумывает факты. Этот недостаток вызывает серьёзные опасения среди программистов и учёных, так как алгоритм используется в разных сферах, включая медицинские учреждения.

Генеративные нейросети, как известно, иногда создают факты на основе своих данных. Однако удивительно видеть этот недостаток у Whisper, который разработан исключительно для преобразования речи в текст. В ходе исследований выявлено, что алгоритм может добавлять в расшифровки несуществующие данные, от расистских высказываний до вымышленных медицинских процедур. Это особенно тревожно, учитывая использование Whisper в больницах.

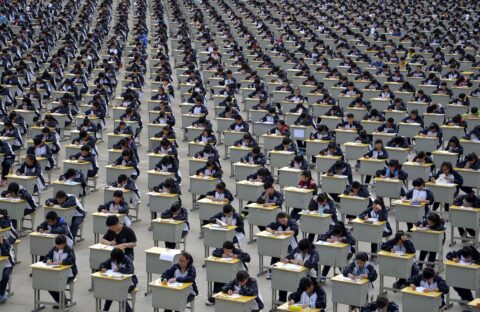

Исследователь из Университета Мичигана, анализируя расшифровки публичных собраний, обнаружил ошибки в восьми из десяти проверенных записей. Другой эксперт, проанализировавший более 100 часов аудиофайлов, расшифрованных Whisper, также выявил ошибки в более чем половине случаев. Третий инженер выявил недостоверные данные практически во всех 26 тысячах расшифровок, выполненных с помощью Whisper.

В OpenAI заявили, что работают над улучшением качества своих нейросетей и уменьшением количества галлюцинаций. Представитель компании отметил, что политика OpenAI ограничивает использование Whisper в критически важных ситуациях. «Мы благодарим исследователей за предоставленные данные», — добавили в OpenAI.

1 Comment