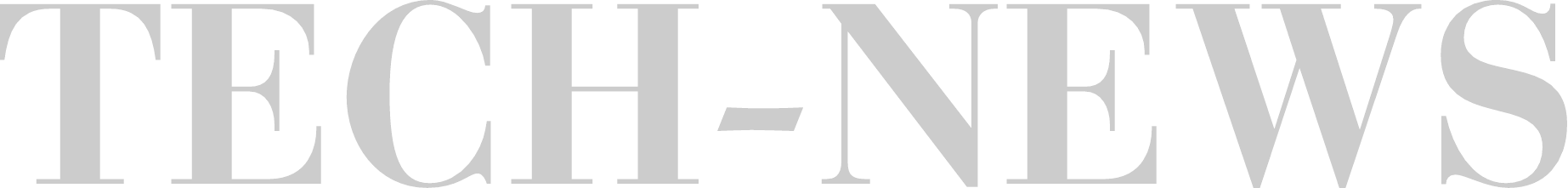

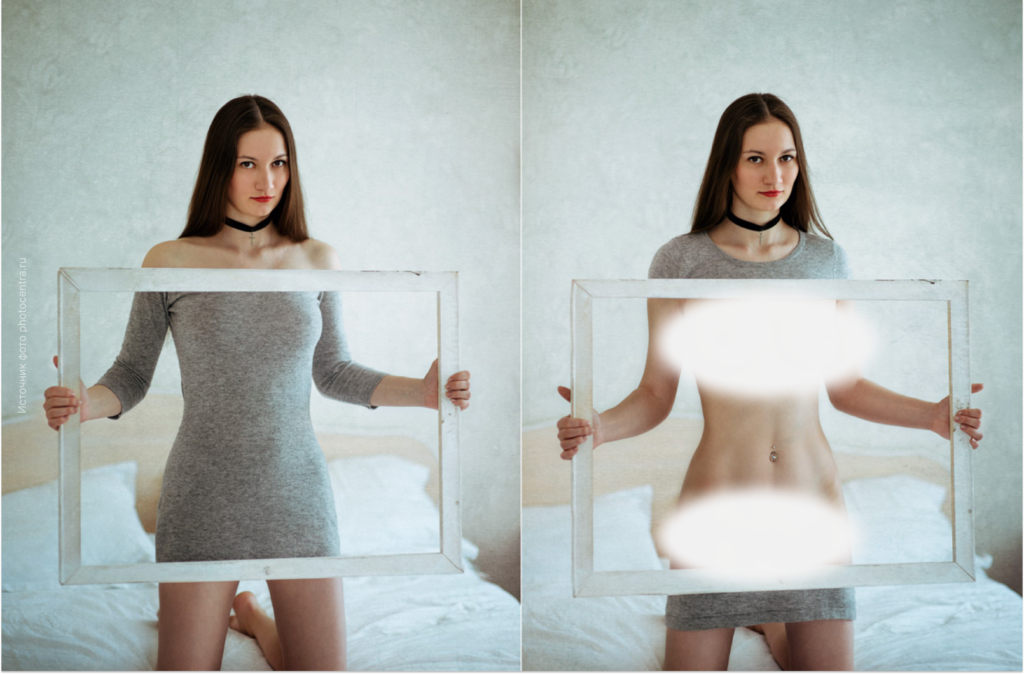

Пользователи все активнее используют ИИ-инструменты Google и OpenAI для создания бикини-дипфейков из обычных фотографий полностью одетых женщин. Если раньше дипфейк означал сложный видеомонтаж с подменой лица, что требовало навыков и времени, то теперь это одна текстовая команда: ИИ сам «переодевает» человека и выдает реалистичное изображение за считанные минуты. Об этом пишет WIRED, отмечая, что речь идет уже не об отдельных случаях, а о массовой практике.

В удаленных ветках Reddit пользователи делились промптами, позволяющими обходить защиту Gemini и ChatGPT, чтобы «переодевать» женщин в откровенную одежду. В одном из постов прямо просили заменить сари на бикини, и кто-то тут же выложил готовый дипфейк. После обращения журналистов Reddit удалил контент и закрыл сабреддит (раздел внутри Reddit, посвященный конкретной теме) r/ChatGPTJailbreak, где было более 200 тысяч подписчиков.

Это часть более широкой проблемы. Сайты формата «nudify» — это сервисы, куда загружают реальные фотографии людей, а ИИ по запросу «раздевает» их, создавая сексуализированные изображения без согласия жертвы. Nudify работают на открытых ИИ-моделях, потому что там нет встроенных запретов и модерации. Сами сервисы часто размещают там, где за подобным контентом никто не следит.

В Google говорят, что такие сценарии нарушают правила, однако методы защиты несмотря на дорабатки не успевают за пользователями. В OpenAI напоминают: менять внешность человека без согласия запрещено, за дипфейки можно получить бан. В Electronic Frontier Foundation считают, что агрессивно сексуализированные изображения — один из главных рисков ИИ-генерации, и чем мощнее становятся инструменты, тем острее встает вопрос ответственности