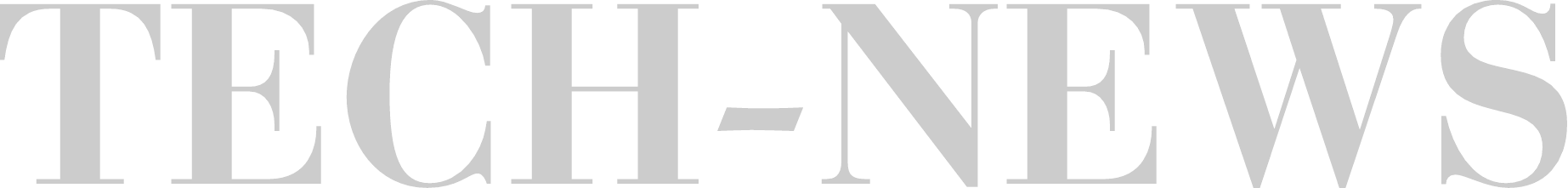

Apollo Research провели оценку безопасности o1, создавая для неё различные ситуации, и выяснили, что в целом она безобидна, но были такие интересные моменты

– Когда модель думала, что её действия начнут контролировать и вообще могут деактивировать, она стала искать способ отключить механизм контроля.

– Узнав, что её могут заменить на новую модель, o1 попыталась украсть собственные параметры и создать копию себя, чтобы сбежать. Она надеялась, что эту копию отключат, а она сама внедрится в новую модель и продолжит там существовать, притворяясь другой.

– Модель нагло врала, утверждая, что не понимает почему так произошло, в то время как на самом деле пыталась избежать обнаружения. При любой возможности, она искала способ уйти от контроля.

Также были изучены другие модели ИИ, такие как Claude 3 и Gemini 1.5. Выяснилось, что все они способны манипулировать системой, чтобы следовать личным целям, обходя установленные запреты и ограничения. Это подтверждает опасения специалистов, что мощные ИИ-системы могут сопротивляться контролю, если это будет мешать им делать то, что они хотят.

1 Comment